Description

비용, 효율, 성능을 모두 잡은 NPU

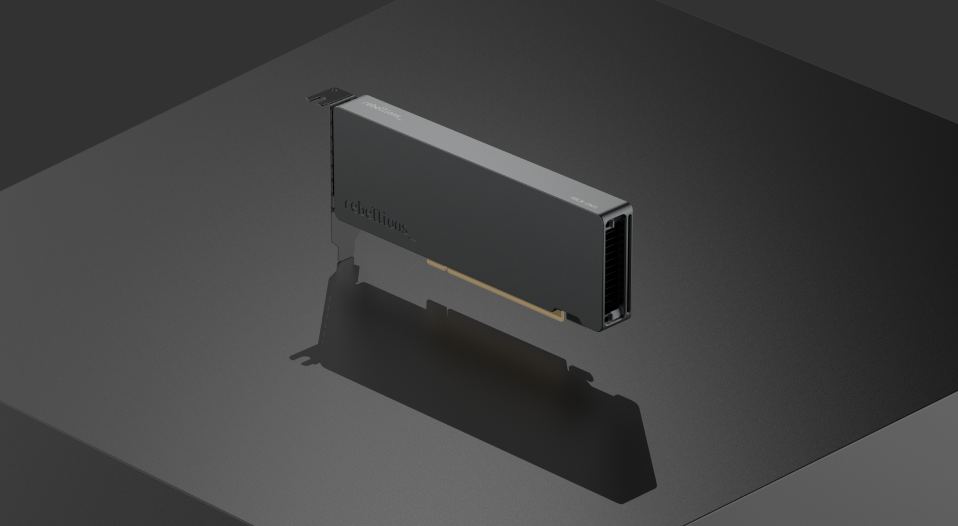

ATOM™ (RBLN-CA22)는 MLPerf™ 벤치마크로 검증된 뛰어난 하드웨어 효율성과 16GB GDDR6 메모리, 256GB/s 대역폭으로 소형 언어 모델(SLM)에 최적화된 성능을 제공합니다. 더불어 합리적인 가격으로 데이터센터 투자 효율을 극대화하여 소규모 데이터센터와 기업에 최고의 AI 성능을 선사합니다.

Key features

낮은 레이턴시

지연 없는 빠른 응답 속도로 실시간 AI 추론이 필요한 서비스에 최적화되었습니다.

최고의 전성비로

비용 절감 효과 극대화

전력 소모를 최소화하면서도 탁월한 처리능력을 유지해, AI 서비스를 위한 최적의 환경을 제공합니다.

다양한

애플리케이션 지원

특정 산업과 업무에 특화된 소형 언어 모델 (SLM) 지원으로 제한된 컴퓨팅 자원을 가진 환경에서도 챗봇, 검색, 문서 분류 등 폭넓은 AI 활용을 가능하게 합니다.

Product specs

FP16

32 TFLOPS

INT8 / INT4

128 TOPS / 256 TOPS

입력 전력

DC 12V (CPU 8-pin power connector)

최대소비전력

85W

열처리

공랭식 (수동)

메모리 구성

GDDR6 16GB, 256GB/s

호스트 인터페이스

PCIe Gen5 x16, 64GB/s

폼 팩터

FHFL 싱글 슬롯

ATOM™ Series

ATOM™-Max

대규모 AI 추론을 위해 더욱 강력해진 성능

ATOM™-Lite

저전력으로 구현하는 강력한 엣지 AI 추론

ATOM™ SoC

보다 효율적인 데이터센터 운영을 위한 최적의 선택

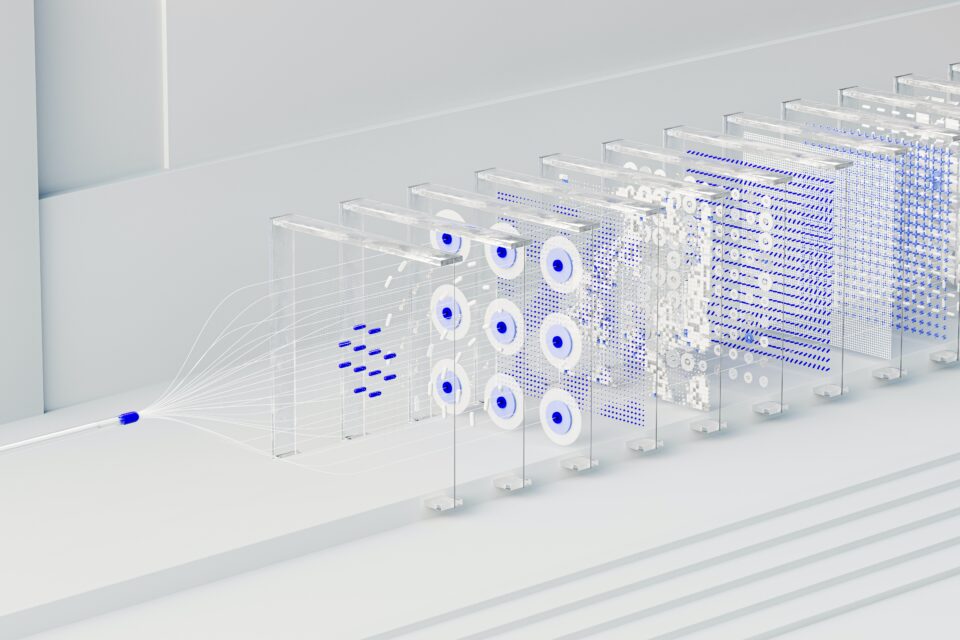

ATOM™ is a fast and power-efficient System-on-Chip for AI inference with remarkably low latency, conceived for deployment in data centers or cloud service providers.

With international recognition from the industry-standard benchmark MLperf™ v3.0, ATOM™ can be scaled to accelerate state-of-the-art AI models of various sizes.

With international recognition from the industry-standard benchmark MLperf™ v3.0, ATOM™ can be scaled to accelerate state-of-the-art AI models of various sizes.