Description

대규모 추론 서비스를 위한 최상의 선택

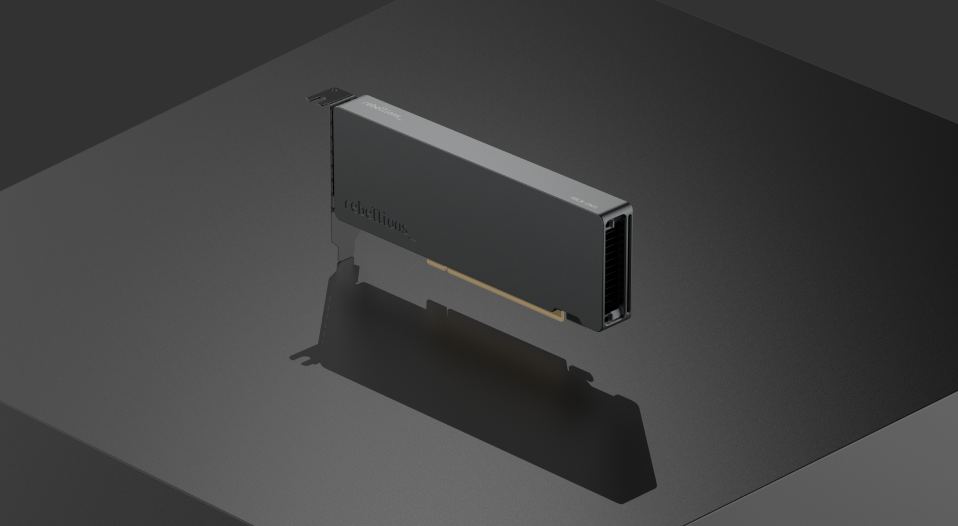

ATOM™-Max(RBLN-CA25)는 대규모의 데이터센터와 기업을 위해 설계된 동급 최고의 AI 가속기입니다. 128 TFLOPS(FP16)와 최대 512 TOPS(INT8) / 1024 TOPS(INT4)의 연산 성능, 1024GB/s의 대역폭으로 대규모 AI 추론 워크로드에서 업계 최고 수준의 효율과 성능을 제공합니다.

Key features

획기적인 성능 향상

AI 연산 속도와 데이터 처리 대역폭을 획기적으로 높여, 한층 강화된 AI 연산 능력으로 기업의 생산성과 경쟁력을 높입니다.

카드 간 직접 통신으로 지연 최소화, 확장성 극대화

PCIe Gen5 x16 기반 카드 간 직접 통신으로 시스템 병목 현상을 줄이고, 손쉽게 규모를 확장할 수 있습니다.

엔터프라이즈급 AI 인프라에 최적화

대규모 사용자 기반의 AI 서비스 기업과 데이터센터 규모의 AI 인프라 구축을 위한 모든 요구사항을 충족합니다.

Product specs

ATOM™ Series

ATOM™

소규모 데이터센터를 위한 지속 가능한 솔루션

ATOM™-Lite

저전력으로 구현하는 강력한 엣지 AI 추론

ATOM™ SoC

보다 효율적인 데이터센터 운영을 위한 최적의 선택

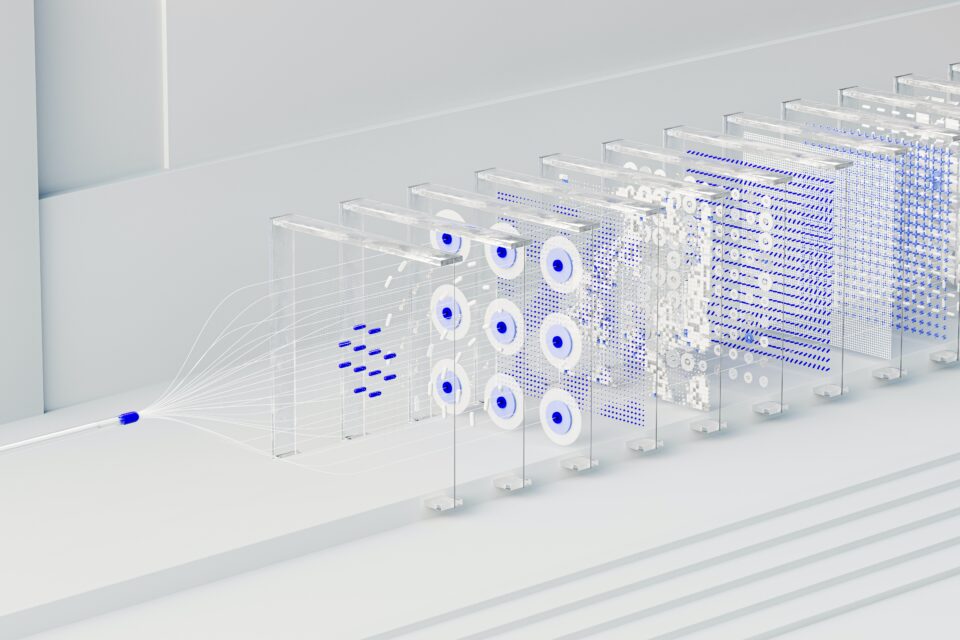

With international recognition from the industry-standard benchmark MLperf™ v3.0, ATOM™ can be scaled to accelerate state-of-the-art AI models of various sizes.